Synthese und Synthesizer

Veröffentlicht am 07/07/2020

Con questo articolo iniziamo un viaggio nel mondo dell'elettronica per la musica. L'obiettivo è descrivere i principi, le tecniche e le tecnologie per la generazione e l'elaborazione del suono in modo semplice ma rigoroso. Questo dovrebbe aiutare tutti quelli che non hanno fatto studi specifici e/o con poca esperienza pratica nel campo del sound engineering a muoversi con cognizione di causa tra sintetizzatori, processori di segnale, effetti e programmi per l'elaborazione musicale.

Cominciamo con capire meglio cosa è un suono e come questo può essere rappresentato in modo da essere elaborato di sistemi elettronici. Partiamo da qui (con un minimo di teoria) perché poi sarà più semplice capire come funzionano oscillatori, filtri, compressori, equalizzatori...

La percezione del suono deriva dalla capacità che ha il nostro organismo di interpretare le vibrazioni dell'aria. Riusciamo ad ascoltare uno strumento musicale che emette un suono perché questo si propaga nell'aria attraverso onde sonore e arriva fino ai nostri “sensori” che traducono il suono in stimoli percepibili dal cervello (che poi sono anch'essi segnali elettrici). Il sensore principale è l'orecchio. Il suono si percepisce però anche attraverso vibrazioni degli altri organi del corpo umano (soprattutto le basse frequenze quando la potenza del segnale è adeguata).

Si parla di onde sonore quando si è in presenza di variazioni nel tempo e nello spazio di pressione sonora. Lo strumento musicale (ma anche ogni cosa che genera rumore) è in grado di attivare la vibrazione delle particelle di aria. Questa vibrazione si propaga (con una velocità di circa 340 metri al secondo) fino a raggiungere gli ascoltatori. Man mano che ci si allontana dalla sorgente (strumento musicale) la vibrazione perde energia e il suono si attenua fino a diventare non più percettibile. L'elettronica ci aiuta a superare i limiti di questa situazione perché utilizzando opportunamente sistemi elettronici possiamo:

niente male per una disciplina che ha mosso i primi passi nei primi anni del secolo scorso. Per trasformare la variazione di pressione in segnale elettrico abbiamo bisogno di un trasduttore. Il microfono fa esattamente questa operazione. Il segnale elettrico può essere elaborato a piacere con i sistemi elettronici. Quando l'elaborazione è fatta su grandezze elettriche che variano in modo analogo alle variazioni di pressione del suono sorgente si parla di sistemi o segnali analogici. Esiste però un altro modo di elaborare il suono facendo ricorso a sistemi che prendono le grandezze elettriche e le trasformano in cifre (che in inglese si dice digit). Per questo tali sistemi/segnali sono detti digitali.

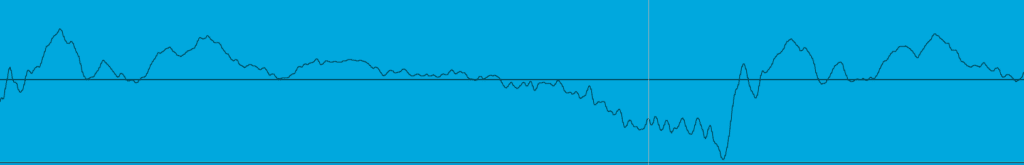

Se guardiamo come varia nel tempo la pressione sonora davanti una capsula di un microfono osserviamo un grafico che ha un andamento del tipo indicato in figura:

Andamento analogo (!) avrà il segnale elettrico all'uscita del microfono. Come vedete la variazione è abbastanza articolata intorno all'asse che rappresenta il tempo (asse orizzontale). L'ampiezza del segnale varia in un modo piuttosto complesso ma per fortuna un certo Fourier (scienziato francese vissuto a cavallo tra 700 e 800) è riuscito a dimostrare che un segnale qualsiasi può essere sempre scomposto in una somma di segnali molto semplici. Questi segnali semplici sono le sinusoidi. Guardiamole da vicino:

Come vedete la variazione è molto regolare. Il segnale oscilla in modo simmetrico intorno allo zero e si ripete periodicamente. Il suo valore massimo determina l'ampiezza. Il tempo che il segnale impiega a compiere un'oscillazione completa si chiama periodo. Il numero di oscillazioni al secondo si chiama frequenza (curiosità: la frequenza è l'inverso del periodo) Per tornare a Fourier, un segnale può essere scomposto in una somma di sinusoidi di frequenza multipla che si chiamano armoniche (la prima armonica è detta anche fondamentale). Fourier ci dice anche come calcolarne le ampiezze ma noi possiamo trascurare la cosa e misurarle con un analizzatore di spettro. Questo è uno strumento che prende un segnale, lo analizza, e mette le armoniche su un asse in funzione della loro frequenza. Ogni armonica è una barra verticale la cui altezza è l'ampiezza della singola armonica. Un segnale sinusoidale ha una sola armonica (non date peso alle imperfezioni di rappresentazione che vedete nella figura, sono colpa dello strumento):

Un segnale più complesso come quello che ha l'andamento di figura 4 (onda quadra) ha, invece, molte armoniche.

Esiste un segnale che le armoniche le ha tutte. Si chiama rumore bianco e si chiama così per analogia con il colore bianco che, come certamente saprete, contiene tutti gli altri colori.

Un segnale analogico che rappresenta un messaggio musicale può essere, in termini di volume, molto forte o molto basso in funzione delle particolari caratteristiche del brano. La differenza tra il valore massimo e quello minimo in termini di ampiezza si chiama dinamica del brano.

I sistemi che elaborano il brano musicale devono essere in grado di gestire correttamente la sua dinamica. La perfezione non è di questo mondo (e nell'audio di imperfezioni ce ne sono tante) e quindi un sistema per elaborare il suono a dei limiti. Verso il basso perché introduce sempre una certa quantità di rumore, verso l'alto perché oltre un certo livello non riesce ad andare per il sopravvenire dei suoi limiti fisici. Affinché un sistema sia in grado di elaborare correttamente un brano audio la differenza tra il suo livello massimo possibile e il livello del rumore generato (così si definisce la dinamica del sistema) deve essere maggiore della dinamica del brano.

Esistono brani ad elevata dinamica (per esempio composizioni di musica classica o jazz) e brani che, nonostante suonino molto forte, hanno una dinamica bassa (molta della musica pop e rock degli ultimi anni).

L'elaborazione analogica dei segnali è stata l'unica possibile fino agli anni '80 circa. Successivamente, con invadenza sempre maggiore, si è affermata l'elaborazione digitale. Il legame (stretto) tra i due mondi è possibile grazie al teorema di Nyquist-Shannon. Questo dice (semplificando) che per raccogliere tutto il contenuto informativo di un segnale basta prenderne solo alcuni campioni (campionando con una frequenza che è pari al doppio della frequenza massima del segnale stesso). Un campione di un segnale è il valore di questo ad un determinato istante. Potendo rappresentare questo valore con dei numeri è possibile ottenere una serie (di numeri o... digit) che contiene tutta l'informazione del segnale originale. Se rappresento i numeri con una serie binaria (successioni di 1 e 0) posso usare i computer per elaborare il suono. Gli oggetti che ci fanno passare dal dominio analogico a quello digitale si chiamano, rispettivamente, convertitori Analog-to Digital (A/D) e Digital-to Analog (D/A).

Se ammettiamo (ma c'è chi dice che non è così) che un segnale audio abbia frequenza massima pari a 20.000 Hz (la frequenza si misura in Hertz pari al numero di oscillazioni al secondo) per avere una rappresentazione completa del segnale nel dominio digitale dobbiamo campionare almeno a 40.000 Hz (o 40KHz).

La lunghezza (in cifre binarie o bit da binary digit) della sequenza di numeri binari che un convertitore A/D è in grado di generare è indicativa della dinamica che il convertitore riesce a gestire. I convertitori odierni sono ormai tutti a 24bit. La dinamica che si riesce a gestire con 24 bit è più che adeguata per la gestione dei segnali musicali. Maggiore è il numero di bit del convertitore e più è accurato il dettaglio della conversione.

Ci fermiamo qui. La prossima volta parleremo del percorso del segnale nei sistemi per musica live. A presto!

Sei dabei und sichere dir 5% Rabatt auf deine nächste Bestellung!

Leerer Wagen